Bildquelle: Wikipedia |

C. Shannon begründete eine Art "Informationstheorie" durch seine "mathematische Theorie der Kommunikation", in welcher er die Hartley-Entropie-Formel auf den technologischen Informationsprozess anwendete. Laut F. Kittler .. " die folgenreichste Magisterarbeit aller Zeiten", in der Shannon den Beweis erbrachte, dass Booles Laws of Thought in elektrische Schaltsignale gegossen werden kann, sowie den lange Jahre vom Pentagon unter Verschluss gehaltenen nicht-öffentlichen Teil der Kommunikationstheorie, den Abschnitt über "Secrecy Systems" (Chiffriersysteme), aus deren Geist die allgemeine "mathematische Theorie der Kommunikation" einst überhaupt erst hervorgegangen ist. C. Shannon konstruierte ein paar lustige Maschinen. C. Shannon begann 1932 ein Elektrotechnik- und Mathematikstudium. 1936 wechselte er mit einem Abschluss in Mathematik und Elektrotechnik an das MIT. In seiner Abschlussarbeit zum Master in Elektrotechnik (1937), A Symbolic Analysis of Relay and Switching Circuits,[3] benutzte er Boolesche Algebra zur Konstruktion von digitalen Schaltkreisen. Die Arbeit entstand aus der Analyse der Relais-Schaltkreise im Analogrechner Differential Analyzer von Vannevar Bush (Dekan der Ingenieurwissenschaften am MIT), den C. Shannon für Anwender programmierte. 1940 erwarb er seinen Doktortitel in Mathematik mit einer Arbeit über theoretische Genetik (An Algebra for Theoretical Genetics) am MIT. Hinweis (quasi in eigener Sache):

|

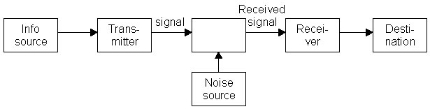

Die Kommunikationstheorie von C. Shannon beinhaltet ein übertragungstechnisches Modell und eine Quantifizierungsformel für "Information":

Als C.Shannon 1948 seine Informationstheorie veröffentlichte, hat sein Co-Autor W. Weaver diese Problematik vollständig ausgedrückt. Er schrieb, dass nicht nur sein Telefonapparat ein Transmitter von Signalen sei, sondern auch sein Sprechapparat: "Im mündlichen Gespräch ist das Gehirn die Informationsquelle, der Stimm-Mechanismus, der die Schallwellen, die durch die Luft (Kanal) übermittelt werden, produziert, ist der Transmitter. (...) Wenn ich mit Ihnen spreche, ist mein Hirn die Informationsquelle, mein vokales System der Transmitter" (Shannon/Weaver:98f).

W. Weaver schreibt: ”Das Wort ,Information‘ wird, in unserer Theorie, in einem spezifischen Sinn verwendet, der nicht mit der üblichen Verwendung des Wortes verwechselt werden darf. (...) Zwei Nachrichten, von welchen die eine wirklich bedeutungsvoll und die andere purer nonsense ist, können, was ihren Informationsgehalt betrifft, unter dem verwendeten Gesichtspunkt, exakt äquivalent sein. Es ist zweifellos diese Tatsache, die Shannon meint, wenn er sagt, dass ,der semantische Aspekt der Kommunikation für den technischen Aspekt irrelevant ist‘” (Shannon:99).

C.Shannon schreibt in seinem epochemachenden Aufsatz: ”In diesem Aufsatz werden wir die Theorie erweitern, um eine Anzahl neuer Faktoren einzuschliessen, insbesondere die Wirkung von Störungen im Kanal und die Einsparungen, die sowohl durch die statistische Struktur der Originalnachricht als auch durch die Art des Endzieles der Information möglich sind” (Shannon/Weaver: 41). In der Theorie von C.Shannon geht es, allgemeinverständlich gesagt, darum, wie viele Gespräche gleichzeitig auf einer Telefonleitung übermittelt werden können, was C. Shannon ”Kanalkapazität” nannte. (Todesco: Technische Intelligenz:213)

Die Formel von C.Shannon für den Informationsgehalt der einzelnen Variablen einer Struktur entspricht der Entropie-Formel: Inf(N)= -logdualP(N). Sie gibt die Zahl der optimalen Ja-Nein-Fragen an, die man stellen muss, um den Wert der Variablen zu identifizieren. Sie ist quasi ein Mass für die Un-Ordnung, da bei Unordnung mehr Fragen nötig sind.

Der ”Kanal” wird häufig sehr nachlässig behandelt. C. Shannon sagt: ”Der Kanal ist nur ein Mittel (...) Es können ein paar Drähte sein, (...) ein Lichtstrahl usw.” (Shannon/Weaver:44). W. Weaver sagt (über den Schalldruck), ”der durch die Luft (den Kanal) übertragen wird”: ”In der Funktechnik ist der Kanal einfach der Raum (oder der Äther, wenn jemand dieses veraltete und irreführende Wort noch bevorzugt), und das Signal ist die elektromagnetische Welle, die übertragen wird” (Shannon/Weaver:16f). Der Linguist U. Weidmann bezeichnet sogar ”die Luft, das Tonband” und den ”Schall” als Kanal (Weidmann,1979,10).

Damit auch die Telefonverbindung als Ganzes als Sender/Empfänger-Modell aufgefasst werden kann, hat C. Shannon die Kommunikationskette um die beiden Instanzen "Quelle" und "Senke" verlängert.

Auch hier gilt, dass keiner der Begründer war. Die FormelH =log2N, mit welcher die nötige Anzahl Fragen H berechnet wird, um ein Element aus einer homogenen Menge mit NElementen zu bestimmen, heisst nach A.Rényi ”Hartley-Formel”, weil sie Hartley im Jahre1928 als erster veröffentlichte (Rényi,1982, 23), worauf auch W. Weaver verweist (Shannon/Weaver:95).

Die Informationstheorie ist vor allem mit den Namen C. Shannon und W. Weaver verknüpft. R. Hartley, auf dessen Schrift C.Shannon unter anderem aufbaut, nannte seine Arbeit bereits 1928 "übertragung von Information".